AI 時代のコンテンツマーケティングに一次情報が必要な理由

記事などのコンテンツ作成に生成 AI を利用する場面は増えていると思います。テーマを考えたり、翻訳したり、下書きを作成したり、または細かなことでも、つい AI に任せたくなる人も多いのではないでしょうか。SEO を目的に記事を量産するためのサービスもあるようです。

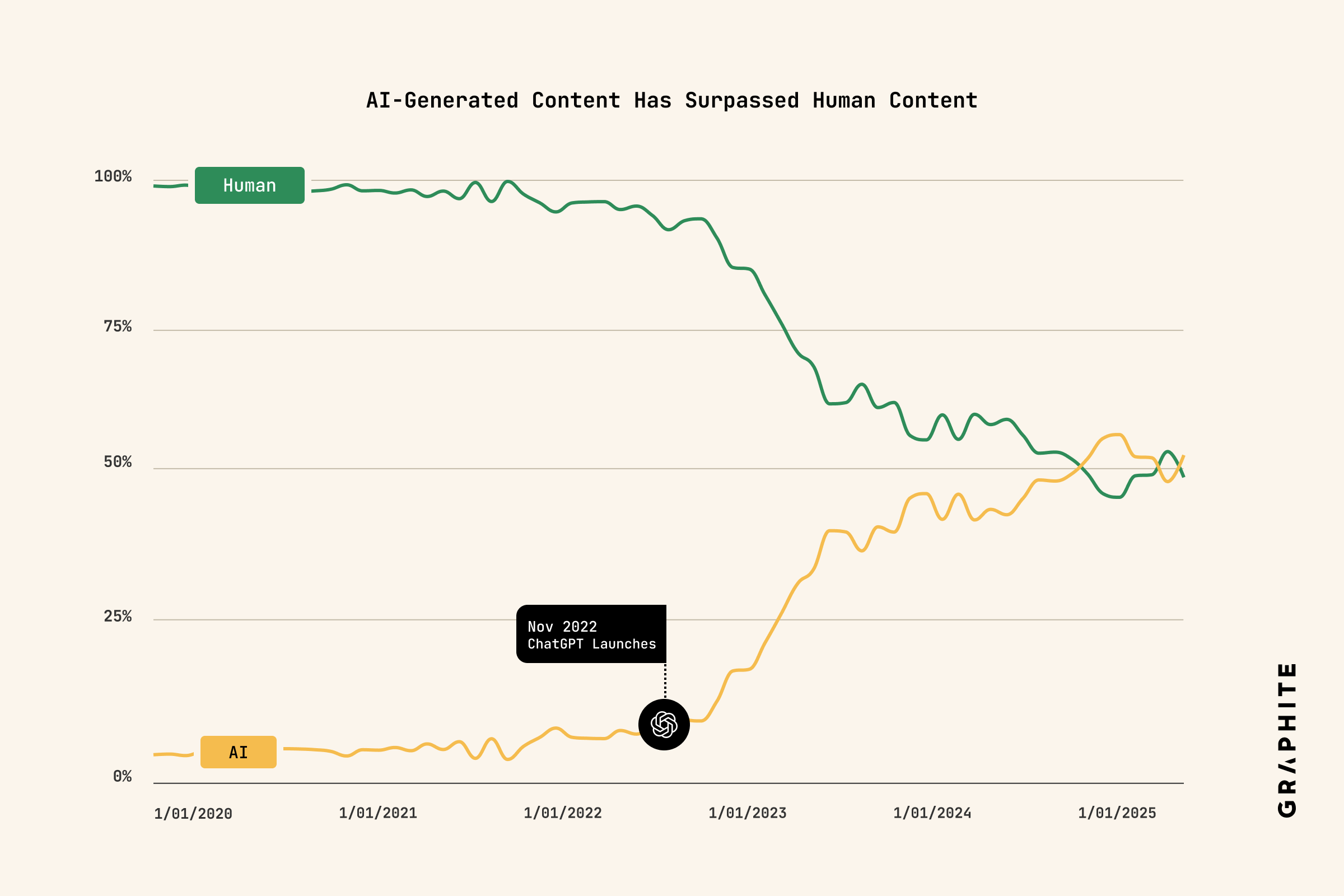

ChatGPT の登場で、インターネットは様変わりしました。3 年経過した現在、1 日に作成される全ての記事の半分以上が AI 生成物に置き換わりました。(参考)

この傾向が続けば、いずれインターネットの大半は AI が生成したものになるでしょう。

一部のネット文化圏で語られる Dead Internet Theory (死んだインターネット理論) は、インターネットの大半がボットや自動生成コンテンツで満たされ、実在の人間の声が統計的なノイズに沈んでいくという見立てです。2021 年に囁かれるようになり、Atlantic 誌が取り上げたことで少し話題にもなりました。もちろん陰謀論的に語られる側面もありますが、生成 AI の普及と、検索・ソーシャルメディアのアルゴリズムに支配されている現状を言い表しているようにも思えます。

同時に進行しているのは、メディアの衰退です。

AI モデルを更新し続けるためにはインターネット上の情報をクロールする必要があります。これまでは検索エンジンのボットがウェブサイトをクロールすることでインデックスされ、結果としてユーザーがウェブサイトを訪れる可能性が高まりました。しかし、AI の普及によりウェブサイトを閲覧するユーザーは減少しています。読者に広告を見せることで収益を上げていたインターネットメディアは、ウェブサイトの訪問者数が減少してしまいました。

皮肉にも、ユーザーの体験は向上しています。たくさんのウェブサイトから選ばずに済むだけでなく、広告が画面の大半を占めるようなウェブサイトを読む必要もないのです。

従来のメディアが打撃を受ける一方、成長しているものもあります。

Reddit は様々なニッチなコミュニティが集まる掲示板サービスです。静的な記事ではなく、ライブ性の高い投稿であることや、個人の意見や経験が反映された内容が多いです。Subreddit というカテゴリに分かれており、その中でユーザー同士で交流しています。ニッチコミュニティの活性化と検索トラフィックが相乗して、投稿数・コメント数・滞在時間いずれも成長しています。

また、以前より続く傾向ですが、個人の発信力はますます強くなっています。ソーシャルメディアで発信する個人や、Dan Shipper が率いる Every など、メディアの形は変化しています。

こうしたメディアの特徴のひとつは、一次情報である点です。一般的な情報が飽和しているからこそ、個人の経験や意見、ライブな情報、インサイトの価値が高まっています。情報の加工やコミュニケーションが自動化された世界では、世の中に新たな情報を提供することが価値なのです。

LLM はインターネットの平均値

AI サービスの中核にあるのが、LLM(大規模言語モデル)です。LLM は、インターネット上に公開された膨大なテキストを学習し、言語のパターンや知識、文脈のつながりを統計的に捉えることで、もっともらしい文章を生成します。「空は」と言われれば「青い」と続けるような日常的な連想から、複雑な論理展開や専門領域の知識まで、確率的に妥当な次の単語や構文を選び取る仕組みです。

学習に用いられるデータは主にインターネット由来です。ウェブサイト、書籍、学術論文、ニュース記事、Wikipedia、オープンソースのコード、ブログ、フォーラムの投稿など、公開テキストが網羅的に収集され、前処理とフィルタリングを経てモデルの学習に使われます。(近年のモデルは人手によるフィードバック、継続学習、ツールや外部知識ベースの利用など、補助的な手法も取られています。)

LLM は統計的に最も確率の高い出力を選ぶため、一般的には役立つ出力が得られます。一方で、ユニークなコンテンツを作る際には課題が生まれます。多数派の表現や構成に引っ張られ、生成される文章が似通ってしまう傾向があるからです。独創的な視点、一次体験に基づく具体例、最新かつ限定公開の情報、あるいは大胆な仮説や非定型の文体などは、平均をなぞるだけでは得られません。LLM は「広く共有されている知識を、平均的にうまくまとめる」点に強みがある一方で、「差別化」には人間の関与が不可欠です。

従来、Google は記事の品質評価のガイドラインとして「E-A-T」を掲げていましたが、2022 年に「E-E-A-T」に更新されました。

- Experience: 経験

- Expertise: 専門性

- Authoritativeness: 権威性

- Trustworthiness: 信頼性

経験と専門性の違いは重要です。例えば、病気の治療法を医学書に基づいて解説するのは「専門性」ですが、その治療を受けた際の痛みや不安、生活の変化を語れるのは「経験」を持つ当事者だけです。AI は膨大な医学書を学習できても、患者の痛みを感じることはできません。生身の人間だけが語れる文脈や感情が求められているのです。

スケールする一次情報

コンテンツが飽和するなか、一次情報の重要性が増しています。自分自身が経験することを除くと、一次情報を収集するためにはアンケートやインタビューが行われます。

アンケート調査は安価に多くの回答を集めることができます。古くから国勢調査に利用されてきた手法で、全員に対して同じ質問をすることが特徴です。回答を比較しやすいメリットがある一方、浅い回答が多くなりがちで、施策に直接結びつきにくいのが難点です。

他方、インタビューは深い会話が可能です。一人ひとりに自由に質問し、仮説を検証したり、具体的なインサイトを集めることができます。しかし、専門的なスキルが必要になるほか、時間や費用も大きくなります。日常的なコンテンツ制作のサイクルで、毎回インタビューを実施するのは現実的ではありません。特にサンプル数の拡大や対象者の多様化を図るほど、調整コストと分析負荷が大きくなります。

「広さ」と「回答の深さ」はトレードオフの関係にあるのです。

現在、このトレードオフを解消するため、AI によるインタビューの自動化が進んでいます。例えば、ワープスが提供するProbyは、質問が固定される従来のアンケートと異なり、回答内容に応じて AI が自然な深掘り質問を行います。対話を通じて本音やニュアンスを引き出すことで、定性的な一次情報やインサイトを効率的に集めることができます。加えて、対話ログの構造化やタグ付け、インサイト抽出を自動化できるため、コンテンツ制作・施策立案への転用が加速します。

AI インタビューは、これまでコストの壁に阻まれていた「一次情報の民主化」を実現し、継続的にインサイトを収集する基盤になりつつあります。

検索される「記事」から、信頼される「情報源」へ

コンテンツ制作は、初期の「AI に記事を書かせる」フェーズを終え、「AI で付加価値を高める」フェーズへ移行しています。量産よりも、差別化と信頼の構築が問われています。インターネットのノイズに埋もれないためには、一次情報を収集する仕組みを構築し、独自の視点で編集することが重要です。情報の「量」で競うゲームは終わりました。これからの企業発信に求められるのは、一次情報の保有元(ソース)になることです。情報の生産者にならなければなりません。

一次情報は、コンテンツの賞味期限も延ばします。時事ネタやノウハウ解説はすぐに陳腐化しますが、独自のリサーチ結果や顧客の生々しいインサイトに基づいたレポートは、長期間にわたって引用され、参照され続けます。世の中にまだない情報を提示し、インターネット全体の知識を豊かにする姿勢こそが、結果としてブランドの権威性や信頼性を高めるのです。

ワープスは、その一次情報をスケーラブルに収集する AI エージェントを提供しています。その他、各種 AI 活用・DX の支援も行っています。ぜひお気軽にご連絡ください。